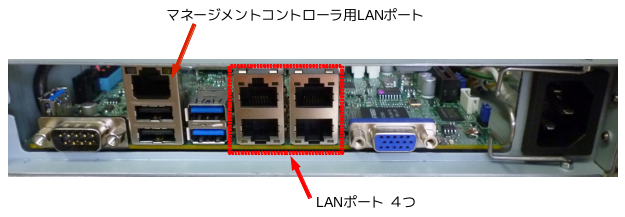

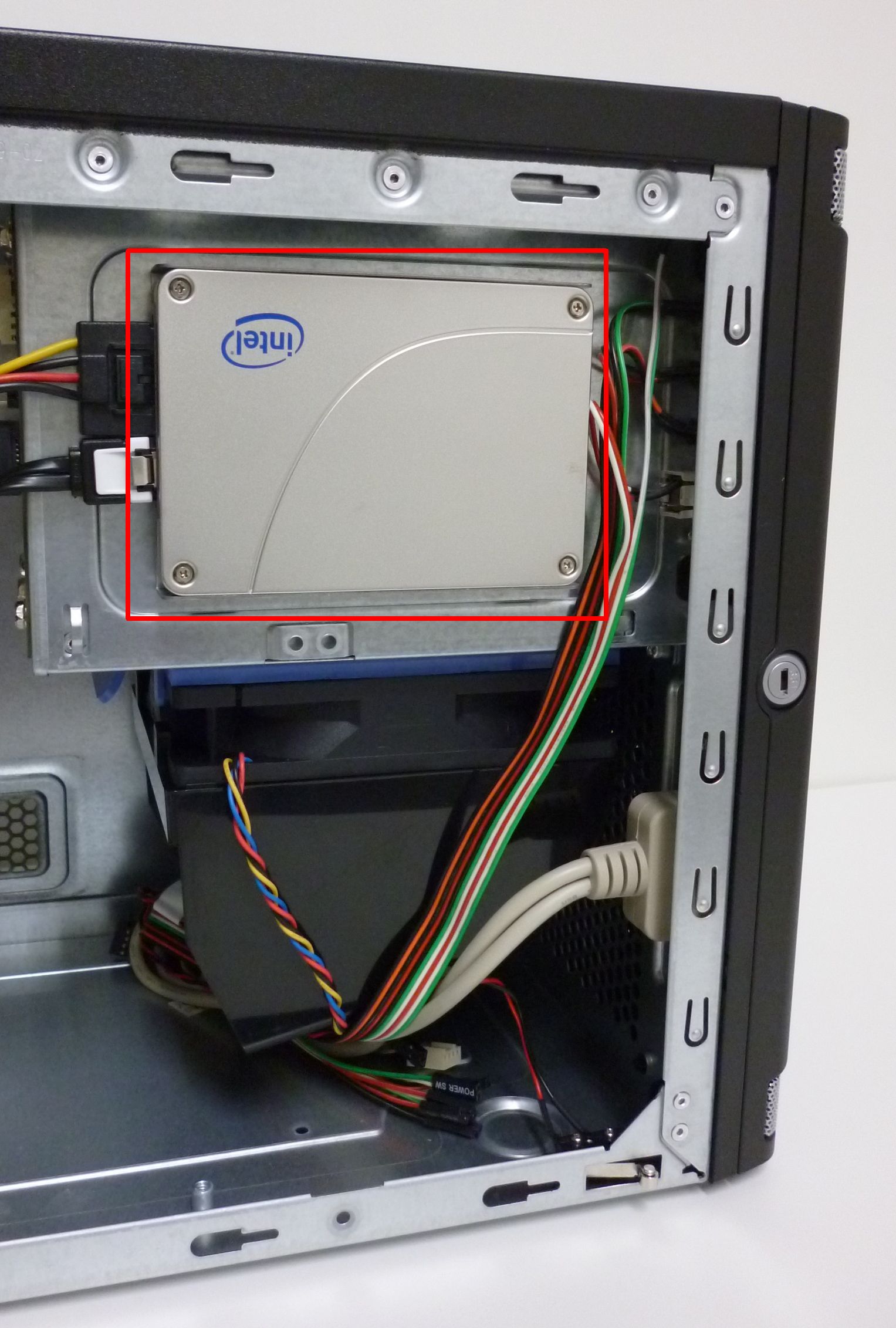

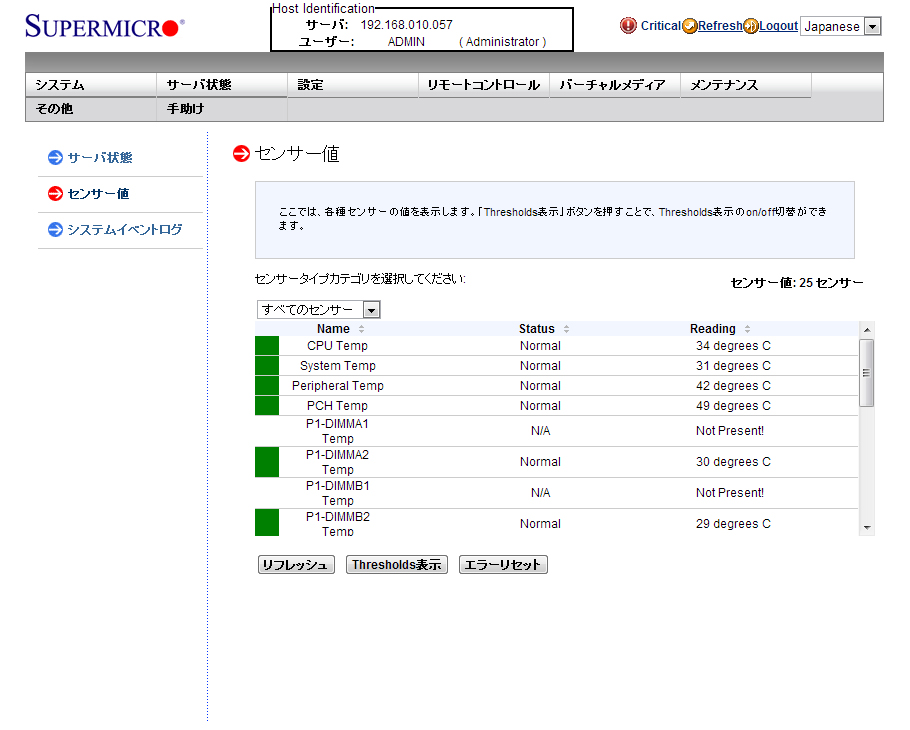

当社のサーバ/ワークステーション製品の多くで、IPMI2.0準拠のマネージメントコントローラを利用出来ます。

マネージメントコントローラはOSとは独立に動作し、CPU温度、ファン回転数の監視したり、リモートでサーバの電源制御などができ、専用LANポート(もしくは、共用LANポート)を介して利用します。

専用LANポートには、サーバ背面のI/Oシールドに”監視”と表記されたシールが貼っています。(ただし、シールを貼ることが出来ない製品には貼っておりません。)

|

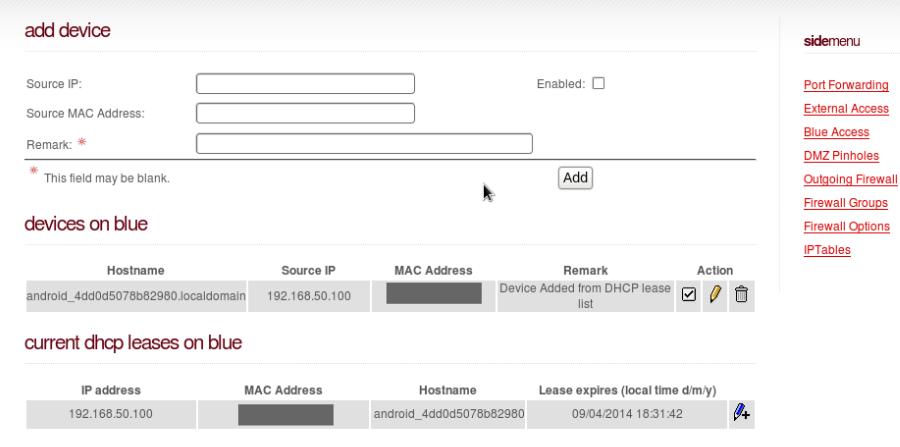

マネージメントコントローラを利用するには、動的もしくは静的にIPアドレスを割り当てて利用します。また、各種IPMIソフトウェアに対応していますので、ソフトウェア(※1)をインストールすれば、ターミナルからも利用出来ます。

|

◎ ターミナルで状態を確認

# ipmitool sdr list

|

◎ イベントをsyslogへ出力

ipmievdを用いるとipmiのイベント出力をsyslogにも出力することが出来ます。

| # service ipmievd start |

テストイベントを発生させ、syslogへの出力を確認します。

|

# ipmitool event 1 Sending SAMPLE event: Temperature – Upper Critical – Going High 0 | Pre-Init Time-stamp | Temperature #0x30 | Upper Criti # tail /var/log/messages |

※1 CentOS6.5でのツールのインストールを例として紹介します。

A OpenIPMIとOpenIPMI-toolsをインストールします。

| # yum install OpenIPMI OpenIPMI-tools |

B ipmiを起動させます。

|

# service ipmi start Starting ipmi drivers: [ OK ] |

C ipmiの起動を確認します。

|

# service ipmi status ipmi_msghandler module in kernel. ipmi_si module in kernel. ipmi_devintf module loaded. /dev/ipmi0 exists. |

D ipmievdを起動させます。

|

# service ipmievd start Starting ipmievd: [ OK ] |

E ipmievdの動作を確認します。

|

# service ipmievd status ipmievd (pid 2753) を実行中… |

F ipmiとipmievdをOS起動時に開始するように設定します。

|

# chkconfig | grep ipmi ipmi 0:off 1:off 2:off 3:off 4:off 5:off 6:off ipmievd 0:off 1:off 2:off 3:off 4:off 5:off 6:off # chkconfig ipmi on |