1CPU当たり32コアを持つEPYC 7501 x 2個と、32GB DDR4-2666 x 32枚(合計1024GB)を搭載するシステムPOWER MASTER Server S5081にて、姫野ベンチマークによる計測を行ってみました。

1CPU当たり32コアを持つEPYC 7501 x 2個と、32GB DDR4-2666 x 32枚(合計1024GB)を搭載するシステムPOWER MASTER Server S5081にて、姫野ベンチマークによる計測を行ってみました。

ちなみに、AMD EPYCには8coreのダイが4つパッケージに入っていて、各々のダイにはメモリ2chとPCIE x16 2本が接続できる構成となっているとのこと。1CPUでメモリ8chとPCIE x16 8本も持っているのです。

【環境】

-

CPU:EPYC 7501 x 2個

メインボード:Supermicro H11DSU-iN

メモリ:32GB DDR4-2666 ECC Registered x 32枚(合計1024GB)

OS:CentOS7.3 x86_64

【テスト】

① シングルスレッド評価

- Compiler: gcc 7.2.1

Benchmark: himenoBMTxp_l(C, dynamic allocate version)

Size: L

② マルチスレッド評価

- MPI: mpich3.2

Compiler: gcc 7.2.1

Benchmark: cc_himenoBMTxp_mpi(C + MPI, static allocate version)

Size: L、XL

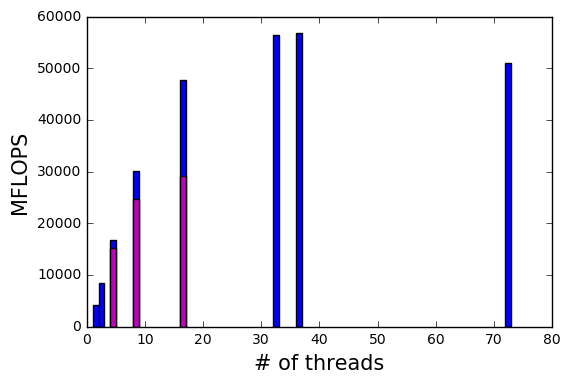

【結果】

[TABLE=26]

[TABLE=27]

(SMT: Simultaneous MultiThreading)

Xeon E5-2680v4とEPYC 7501のシングルスレッド値で比較すると、 EPYC 7501は、Xeon E5-2680v4よりも 約1.35倍の高い結果となっています。

並列計算でもスレッド数64で良い結果となっていますが、スレッド数128では値が少し下がっていて、このあたりがメモリ帯域の限界ではなかろうか?

いずれにしても、すでに持っているバイナリ(アプリケーション)で、パフォーマンス向上を目指すならば、AMD EPYCは良い選択肢となるかもしれません。