■テスト環境

計算ノード 2台

MB: TYAN Toledo i3210W

Chipset: INTEL 3200

CPU: Intel Core2Quad Q9450

MEM: 4GB (DDR2-800 2GB x 2)

インターコネクト

100Base: Intel EtherExpress Pro/100 S Desktop Adapter

1000Base: オンボード (Intel 82573)

Infiniband: Mellanox MHGS18-XTC (DDR)

ベンチマーク

MPI: openMPI

Compiler: gcc 4.1.2

Benchmark: himenoBMTxp

Size: L

■テスト方法

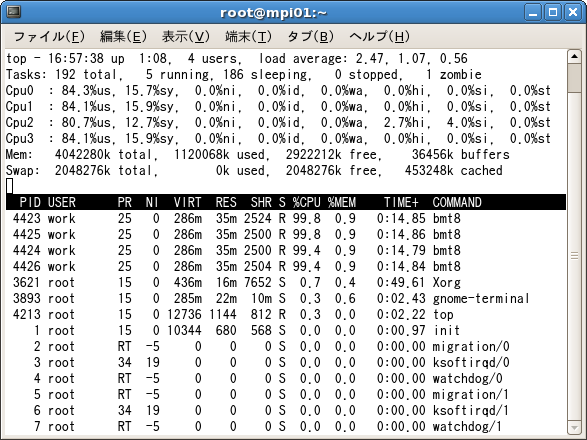

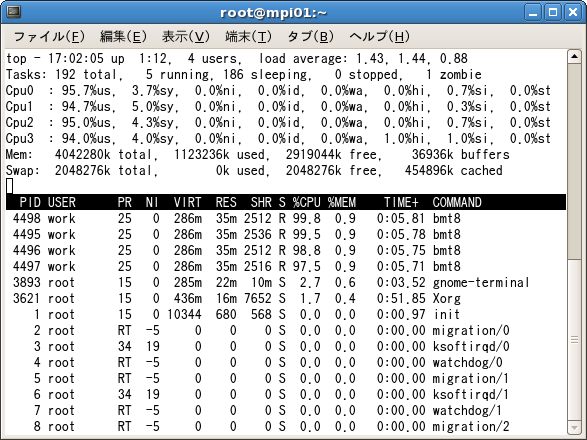

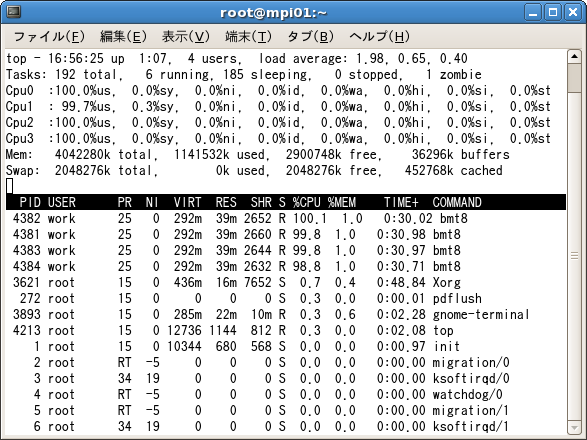

N=8で姫野ベンチを実行し、投入ホストにてtopコマンドでシステムプロセス値を比較

評価

計算ノード2台だけでもこれだけの違いが見られた。

インターコネクトによるパフォーマンス劣化を避けるためにHPC向け高速インターコネクトであるInfiniband選択は大変有効であると再認識をしました。