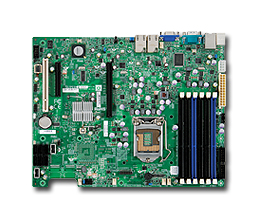

MB: Supermicro X8SIE-F

Chipset: Intel 3420

CPU: Xeon X3430

MEM: 4GB (DDR3-1333 2GB x 2)

MPI: openMPI

Compiler: gcc 3.4.6

Benchmark: himenoBMTxp

Size: L

1CPU 4core: 3089MFLOPS

InfinibandがEthernetと比べてパフォーマンス向上には大変有利であることは以前の検証結果からも言えることです。

今回は、ホスト数が増えた場合にどの程度のシステムプロセス値の差が出るかを検証することにしました。

Intel Core i7は、Quad CoreですがIntel Hyper-Threading TechnologyによりOS上からは倍のCPUが認識できます。

今回のテストでは、分割数を多くすることでネットワーク負荷を高くすることを目的とするために、Intel Hyper-Threading Technologyで認識された論理CPUにもジョブを配分することにしました。

■テスト環境

計算ノード 10台

MB: Supermicro X8STi

Chipset: INTEL X58

CPU: Intel Core i7 920

MEM: 12GB (2GB DDR3-1066 x 6)

インターコネクト

1000Base: オンボード (Intel 82574L)

Infiniband: Mellanox MHGS18-XTC (DDR)

ベンチマーク

MPI: openMPI

Compiler: gcc 4.1.2

Benchmark: himenoBMTxp

Size: XL

■テスト方法

N=80で姫野ベンチを実行し、投入ホストにてtopコマンドでシステムプロセス値を比較

評価

1000Base Ethernetでは、おおよそ23%のCPUリソースがシステムプロセスとして消費してしまう。

特に多計算ノードによるMPIな流体計算では、このCPUリソースを計算に使えることができるinfinibandを選択することは必須と感じた。

■テスト環境

計算ノード 2台

MB: TYAN Toledo i3210W

Chipset: INTEL 3200

CPU: Intel Core2Quad Q9450

MEM: 4GB (DDR2-800 2GB x 2)

インターコネクト

100Base: Intel EtherExpress Pro/100 S Desktop Adapter

1000Base: オンボード (Intel 82573)

Infiniband: Mellanox MHGS18-XTC (DDR)

ベンチマーク

MPI: openMPI

Compiler: gcc 4.1.2

Benchmark: himenoBMTxp

Size: L

■テスト方法

N=8で姫野ベンチを実行し、投入ホストにてtopコマンドでシステムプロセス値を比較

評価

計算ノード2台だけでもこれだけの違いが見られた。

インターコネクトによるパフォーマンス劣化を避けるためにHPC向け高速インターコネクトであるInfiniband選択は大変有効であると再認識をしました。