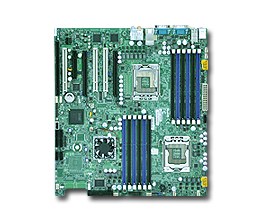

MB: Supermicro X8DAi

MB: Supermicro X8DAi

Chipset: Intel 5520

CPU: Xeon X5677

MEM: 48GB (DDR3-1333 8GB ECC Reg x 6)

MPI: openMPI

Compiler: gcc 3.4.6

Benchmark: himenoBMTxp

Size: L

2CPU 8core: 13909MFLOPS

MPI: openMPI

Compiler: gcc 3.4.6

Benchmark: himenoBMTxp

Size: XL

2CPU 8core: 15153MFLOPS